谷歌大脑最新操作玩“复古”:不用卷积注意力,图像分类接近SOTA

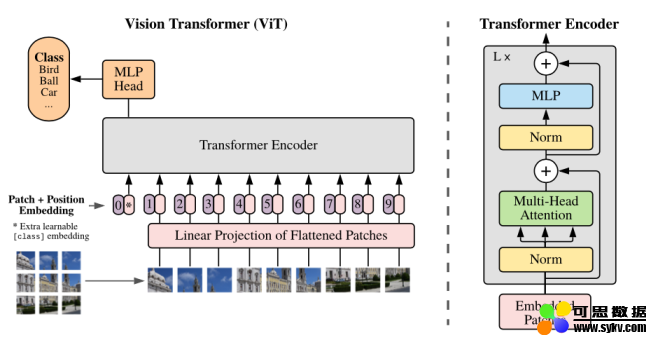

谷歌大脑的视觉Transformer团队(ViT),搞了个复古操作。

他们不用卷积神经网络(CNN)、也不用Transformer,仅凭最早的AI视觉任务采用的多层感知机(MLP)结构,就实现了接近SOTA的性能,更是在ImageNet图像分类任务上取得了87.94%的准确率。

这个架构名为MLP-Mixer,采用两种不同类型的MLP层,可以看做是一个特殊的CNN,使用 1×1卷积进行通道混合(按位操作),同时全感受野和参数共享的的单通道深度卷积进行字符混合(跨位操作)。

在JFT-300M数据集上预训练、微调到224分辨率的Mixer-H/14版本取得了86.32%的准确率,比SOTA模型ViT-H/14仅低0.3%,但运行速度是其2.2倍。

论文地址:

https://arxiv.org/abs/2105.01601

项目地址:

https://github.com/google-research/vision_transformer/tree/linen

时间:2021-05-06 16:07 来源:未知 转发量:次

声明:本站部分作品是由网友自主投稿和发布、编辑整理上传,对此类作品本站仅提供交流平台,转载的目的在于传递更多信息及用于网络分享,并不代表本站赞同其观点和对其真实性负责,不为其版权负责。如果您发现网站上有侵犯您的知识产权的作品,请与我们取得联系,我们会及时修改或删除。

相关文章:

相关推荐:

网友评论: